Il y a des chiffres qui racontent une histoire mieux qu’un long discours. En trois ans, Anthropic est passée de zéro à 14 milliards de dollars de revenus annualisés, avec une croissance supérieure à 1 000 % par an. Fondée en 2021 par Dario et Daniela Amodei, deux transfuges d’OpenAI portés par une conviction — que l’intelligence artificielle doit être développée de manière responsable — l’entreprise a atteint en février 2026 une valorisation de 380 milliards de dollars. Soit davantage que la plupart des banques mondiales.

Ce n’est pas un hasard. C’est un signal.

L’ère des modèles responsables

Ce qui distingue Anthropic dans la course à l’AI, ce n’est pas seulement la puissance de Claude — c’est la philosophie qui l’anime. L’approche dite de « Constitutional AI » pose un cadre éthique directement dans l’architecture du modèle : être utile, inoffensif, honnête. À l’heure où l’Union européenne déploie l’AI Act et où les entreprises exigent des garanties sur la confidentialité de leurs données, cette posture n’est plus idéaliste. Elle est devenue un avantage concurrentiel.

OpenAI domine le grand public avec ChatGPT et ses 700 millions d’utilisateurs hebdomadaires. Mais Anthropic a choisi un terrain peut-être plus durable : l’entreprise. 380 000 organisations utilisent déjà Claude, attirées par des garanties de sécurité et de transparence que les géants peinent à offrir.

La question qui se pose maintenant dépasse la simple compétition entre modèles. Elle est structurelle : comment garantir la confiance dans un monde où l’AI prend des décisions de plus en plus critiques ?

La blockchain : l’autre révolution de la confiance

Pendant que l’AI accélérait, une autre technologie mûrissait en silence. La blockchain — longtemps réduite aux cryptomonnaies et à la spéculation — a discrètement trouvé sa vocation industrielle : certifier, tracer, prouver.

Un registre distribué, immuable, transparent. Pas d’autorité centrale. Pas de falsification possible. Les cas d’usage se sont multipliés : chaînes d’approvisionnement, identité numérique, vote électronique, tokenisation d’actifs, contrats intelligents. Mais il manquait un catalyseur pour passer de l’infrastructure à l’intelligence.

L’AI pourrait bien être ce catalyseur.

Le marr(ll)iage : quand AI et blockchain se tissent ensemble

Le jeu de mots n’est pas anodin. Entre mariage et maillage, il y a plus qu’une lettre de différence — il y a une vision. Car l’avenir ne réside probablement pas dans la fusion brutale de deux technologies, mais dans leur entrelacement fin, leur maillage.

Voici les fils de cette trame.

1. La traçabilité des décisions AI

L’un des reproches les plus fréquents adressés à l’intelligence artificielle est son opacité. Pourquoi ce diagnostic médical ? Pourquoi ce refus de crédit ? Pourquoi cette recommandation plutôt qu’une autre ? La blockchain pourrait servir de journal de bord infalsifiable : chaque décision significative d’un modèle AI serait enregistrée, horodatée, vérifiable. Non pas pour ralentir l’AI, mais pour lui donner une mémoire publique.

Anthropic, avec son travail pionnier en interprétabilité mécaniste — comprendre pourquoi un modèle produit telle réponse — est particulièrement bien placée pour alimenter cette convergence. Quand on sait expliquer une décision, on peut aussi la certifier.

2. L’identité et la provenance des contenus

À l’ère des deepfakes et du contenu généré, comment distinguer le vrai du fabriqué ? La combinaison AI + blockchain offre une réponse : des certificats d’authenticité numériques. Un document produit par Claude pourrait être signé cryptographiquement, son origine vérifiable sur une chaîne publique. Inversement, un contenu humain pourrait être certifié comme tel.

Des initiatives comme le C2PA (Coalition for Content Provenance and Authenticity) vont déjà dans cette direction. Mais elles manquent encore d’un tissu technologique assez fin pour devenir un standard universel. Le maillage AI-blockchain pourrait l’offrir.

3. Les agents autonomes : au-delà des smart contracts

Imaginons un agent AI capable de négocier, commander, payer — sans intervention humaine. C’est déjà techniquement possible. Mais comment encadrer cette autonomie ?

La réponse intuitive — les smart contracts Ethereum — est aussi la plus fragile. Le modèle Solidity, Turing-complet par nature, offre une surface d’attaque immense : le hack du DAO, les exploits de bridges, les failles de réentrance. Pour des agents AI autonomes manipulant des fonds en temps réel, c’est un risque inacceptable.

Des architectures plus récentes offrent une voie plus sûre. Le XRP Ledger, par exemple, a introduit les Hooks — des modules WebAssembly légers, volontairement non Turing-complets, qui s’exécutent directement au Layer 1. Pas de logique complexe sur la chaîne, mais une exécution prévisible, rapide (3 à 5 secondes), quasi gratuite (0,01 $), et nativement pensée pour les paiements. Un agent Claude qui négocie un approvisionnement pourrait déclencher un règlement via un Hook XRPL — la blockchain garantit l’exécution, l’AI garantit le jugement, et la simplicité du code réduit drastiquement la surface d’attaque.

Le XRPL embarque aussi nativement un échange décentralisé, des escrows et des canaux de paiement — sans recourir à des contrats complexes. C’est une architecture sobre, où la sécurité naît de la contrainte plutôt que de l’ambition.

4. La vérification des décisions AI : une couche de confiance matérielle

Entraîner un modèle comme Claude coûte des centaines de millions de dollars. Mais le vrai défi n’est pas le calcul — c’est la preuve que le calcul a été fait correctement.

C’est exactement le terrain qu’occupe Hedera Hashgraph. Son architecture DAG (graphe orienté acyclique), radicalement différente d’une blockchain classique, traite 10 000 transactions par seconde avec une finalité en moins de cinq secondes, pour un coût infime et un bilan carbone négatif. Mais surtout, Hedera a construit en 2025 un pont direct entre AI et registre distribué : son partenariat avec NVIDIA permet d’enregistrer sur la chaîne Hedera les preuves de conformité et le comportement d’agents AI exécutés sur les puces Blackwell — un audit matériel et logiciel, vérifiable en temps réel.

On ne parle plus de promesses. On parle d’agents AI dont chaque décision est ancrée dans un registre public, avec une attestation matérielle.

Un bémol s’impose toutefois. Le conseil de gouvernance de Hedera — Google, IBM, Boeing, FedEx — lui confère une crédibilité institutionnelle indéniable, mais pose une question légitime : est-ce encore de la décentralisation quand un consortium de multinationales tient les clés ? Le hashgraph offre l’infrastructure ; la philosophie, elle, reste un chantier ouvert. C’est honnête de le dire.

5. La gouvernance collective de l’AI

Qui décide des règles qu’un modèle AI doit suivre ? Aujourd’hui, ce sont les entreprises qui le développent. Demain, ce pourrait être une communauté — via des mécanismes de gouvernance décentralisée inspirés des DAO (Decentralized Autonomous Organizations). Les utilisateurs voteraient sur les principes éthiques, les priorités de développement, les limites à ne pas franchir.

Anthropic a déjà expérimenté cette idée avec des consultations publiques sur le comportement de Claude. La blockchain pourrait transformer ces consultations en processus de décision formels, transparents et contraignants.

Les obstacles sont réels

Il serait naïf de peindre ce tableau sans ombres. Les blockchains de première génération souffrent de lenteur et de coûts imprévisibles — Ethereum en tête. Des architectures alternatives comme le XRP Ledger ou Hedera y répondent techniquement, mais soulèvent d’autres questions : la décentralisation réelle de Hedera, gouverné par un consortium de multinationales, reste un sujet de débat. La complexité réglementaire — déjà considérable pour l’AI seule — se démultiplie quand on y ajoute la crypto et les actifs numériques. L’EU AI Act entre en pleine application en août 2026 ; les cadres réglementaires crypto varient d’un continent à l’autre.

Par ailleurs, toutes les entreprises AI ne partagent pas la même vision. OpenAI, malgré son nom, a opté pour un modèle de plus en plus fermé. xAI d’Elon Musk joue la carte de la provocation et de la vitesse plutôt que de la prudence. La convergence AI-blockchain n’a de sens que si elle est portée par des acteurs qui valorisent la transparence. Et sur ce terrain, Anthropic a une longueur d’avance.

Le cas OpenAI : anatomie d’un coup de poker à 100 milliards

Mais avant de regarder l’horizon, il faut regarder le gouffre. Car l’industrie de l’AI est en train de jouer une partie dont les enjeux financiers dépassent tout ce que la tech a connu — y compris la bulle internet de 2000.

En février 2026, OpenAI négocie une levée de fonds de 100 milliards de dollars, pour une valorisation cible de 830 milliards — davantage que le PIB de l’Argentine. L’entreprise projette 14 milliards de dollars de pertes pour la seule année 2026, avec des pertes cumulées attendues de 115 milliards d’ici 2029. La rentabilité n’est pas espérée avant les années 2030.

Ces chiffres donnent le vertige. Mais c’est la structure de cette levée qui devrait alarmer.

Le circuit fermé : quand les fournisseurs financent leur propre client

Nvidia avait annoncé un investissement pouvant atteindre 100 milliards dans OpenAI — un argent qui, de l’aveu même de la directrice financière d’OpenAI, « reviendrait à Nvidia » sous forme d’achats de GPU. Nvidia est par ailleurs investisseur majeur de CoreWeave, qui fournit la capacité cloud à OpenAI et dépense des milliards pour acheter… des puces Nvidia.

On ne parle plus d’un marché. On parle d’un circuit fermé, où l’argent tourne entre fournisseurs et clients sans créer de valeur externe vérifiable. D’ailleurs, fin janvier 2026, les négociations entre Nvidia et OpenAI se sont effondrées — Bloomberg et le Wall Street Journal ont rapporté des inquiétudes internes chez Nvidia sur le risque de cette opération.

Amazon négocie jusqu’à 50 milliards d’investissement, tout en étant déjà le partenaire cloud d’OpenAI et l’investisseur principal d’Anthropic, son concurrent direct. SoftBank, qui avait mené la levée de 40 milliards en 2025, revient à hauteur de 30 milliards. Chaque acteur couvre ses paris. Personne ne mise sur une seule issue.

Un effet de levier systémique

Le mot « levier » n’est pas exagéré. Quand des montants de cette ampleur dépendent d’hypothèses de croissance non encore réalisées, le risque se propage bien au-delà de la Silicon Valley. Les banques, fonds souverains et intermédiaires financiers qui participent à ces tours de table s’exposeraient, en cas de correction, à des dépréciations massives sur des investissements et produits structurés dont la valeur repose entièrement sur le succès du pari AI.

Le FMI a d’ailleurs averti : la concentration des valorisations sur quelques acteurs « gagnants » reflète une conviction narrative — l’AI transformera tout — plutôt que des flux de trésorerie prouvés. Si ce récit s’affaiblit, même sans effondrement technologique, une simple normalisation des attentes déclencherait des corrections en chaîne.

Le parallèle avec la bulle dotcom est structurel. Les valorisations d’aujourd’hui ne reflètent pas des performances actuelles mais un futur hypothétique. Et l’histoire montre que l’écart entre promesse et réalité finit toujours par se refermer — parfois brutalement.

L’érosion silencieuse

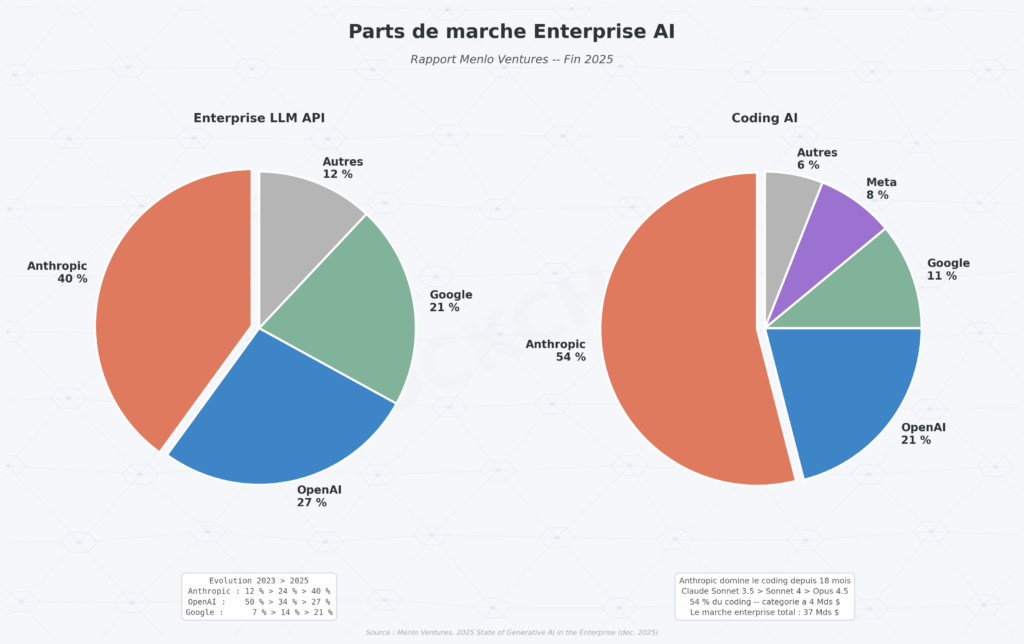

Pendant qu’OpenAI lève des sommes record, sa position de marché s’effrite. La part de trafic web de ChatGPT est passée de 86,7 % en janvier 2025 à 64,5 % un an plus tard — une chute de 22 points, au profit principalement de Google Gemini. Sur le marché entreprise, la part d’OpenAI a reculé à 27 %, tandis qu’Anthropic est montée à 40 %.

Sam Altman a lui-même déclaré un « Code Red » en décembre 2025, gelant des initiatives commerciales pour concentrer les ressources sur l’amélioration de ChatGPT face à la montée de Gemini 3 et Claude. Ce n’est pas le comportement d’une entreprise en position de force. C’est un signe de panique maîtrisée.

Deux philosophies, deux trajectoires de risque

La comparaison avec Anthropic est éclairante. Les deux entreprises affichent un ARR comparable — environ 14 milliards de dollars chacune. Mais la valorisation d’Anthropic (380 milliards) représente moins de la moitié de celle visée par OpenAI (830 milliards). La structure de coût est plus légère. La dépendance aux méga-investissements circulaires, bien moindre. Et la croissance enterprise, plus forte.

Comme le résume un professeur de Stanford : la seule manière de justifier les montants d’OpenAI est de croire que l’AI va fondamentalement transformer le pays, la société et le monde entier. Sinon, ces chiffres n’ont simplement aucun sens.

C’est précisément ici que la question de la blockchain rejoint celle de la finance. Car ce dont l’industrie AI a le plus besoin aujourd’hui, ce n’est pas de plus de capital. C’est de plus de transparence — sur les coûts réels, les revenus réels, les dépendances réelles. Une traçabilité financière que la blockchain pourrait précisément offrir : des audits en temps réel, des engagements vérifiables, des flux de capitaux traçables sur un registre public.

L’ironie serait que la technologie née pour décentraliser la finance devienne l’outil qui empêche la prochaine bulle AI d’éclater dans l’ombre.

Le paysage en 2026 : une fenêtre qui s’ouvre

Regardons la carte. Douze acteurs majeurs se partagent aujourd’hui le terrain de l’AI générative. Les trois premiers — OpenAI, Anthropic, xAI — représentent à eux seuls près de 1 500 milliards de dollars de valorisation cumulée. C’est plus que le PIB de l’Espagne.

Mais la concentration n’est pas une fatalité. Mistral AI, depuis Paris, prouve qu’un acteur européen peut exister face aux géants américains avec une valorisation de 13,8 milliards de dollars et le soutien actif de l’Élysée. Cohere, depuis Toronto, prépare une entrée en bourse. DeepSeek, depuis Hangzhou, a ébranlé les certitudes du marché en janvier 2025 avec un modèle open source rivalisant avec les meilleurs pour une fraction du coût.

La prochaine vague ne sera pas celle qui produit le modèle le plus gros. Ce sera celle qui inspire le plus de confiance. Et c’est là que le maillage AI-blockchain trouve sa raison d’être : offrir une infrastructure de confiance à la hauteur de la puissance déployée.

Conclusion : tisser plutôt que fusionner

Le futur de l’AI ne se joue pas dans une course au gigantisme. Il se tisse — fil par fil, connexion par connexion — dans la capacité à rendre cette technologie vérifiable, traçable, gouvernable. La blockchain n’est pas la réponse à tout. Mais elle offre quelque chose que l’AI seule ne peut pas produire : une preuve.

Le cas OpenAI nous le rappelle avec une clarté brutale. On peut lever 100 milliards et rester fragile. On peut dominer un marché et le voir s’éroder en douze mois. On peut promettre la transformation du monde et ne pas savoir quand viendra le premier dollar de profit. La taille n’est pas la solidité. L’opacité n’est pas la puissance.

Anthropic, avec sa croissance fulgurante et sa philosophie de développement responsable, incarne peut-être le mieux l’intuition inverse. Pas parce qu’elle est la plus grosse — elle ne l’est pas. Mais parce qu’elle pose les bonnes questions : comment construire une AI en qui l’on peut avoir confiance ? Comment croître sans dépendre de circuits financiers circulaires ? Comment être rentable avant d’être colossal ?

Le mariage de l’AI et de la blockchain sera un maillage patient, pragmatique, progressif. Pas un coup de foudre. Un tissage. Et dans un monde où des levées de 100 milliards peuvent s’effondrer entre un tweet et un article du Wall Street Journal, c’est peut-être la patience — plus que l’effet de levier — qui fera la différence.

Comme tout bon tissage, il tiendra parce que chaque fil renforce l’autre. Et parce qu’on peut vérifier chaque nœud.